8 月 23 日消息,科技媒體 9to5Mac 今天發(fā)布博文,報道稱蘋果研究團隊開源 SlowFast-LLaVA-1.5 長視頻多模態(tài)大語言模型,在 1B、3B、7B 參數(shù)規(guī)模下,均刷新 LongVideoBench、MLVU 等 SOTA 基準紀錄。

當前大語言模型在處理和理解視頻方面,通用做法是在 AI 預訓練中集成視頻感知,但這種做法存在以下 3 重局限性:

現(xiàn)有現(xiàn)有模型往往嚴重依賴長上下文窗口,而處理時通常會遇到大量冗余幀,易超出上下文窗口限制,從而丟失信息。

大多數(shù)訓練需要復雜的多階段訓練管道(通常使用私有數(shù)據(jù)集),難以重現(xiàn)。

許多模型僅針對視頻任務優(yōu)化,限制了在圖像的理解,從而降低通用模型的實用性。

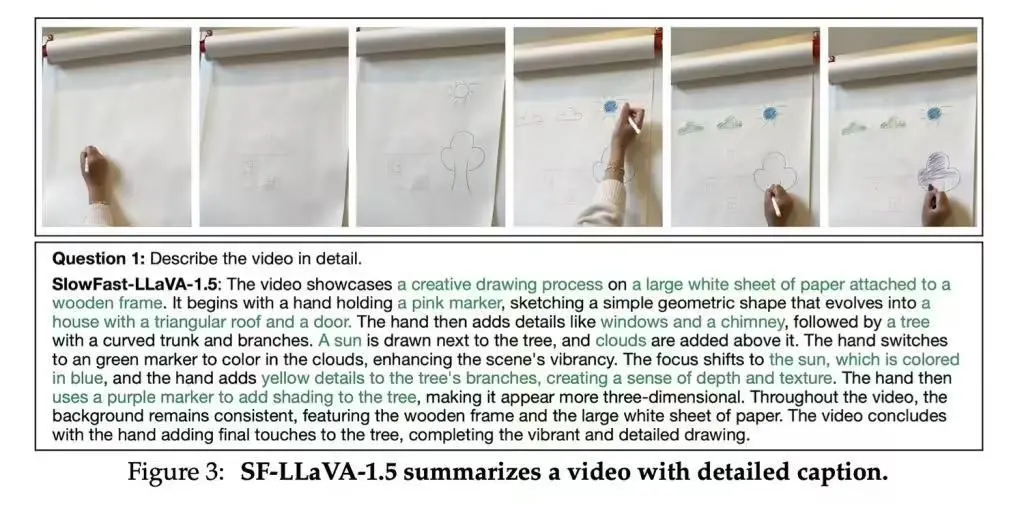

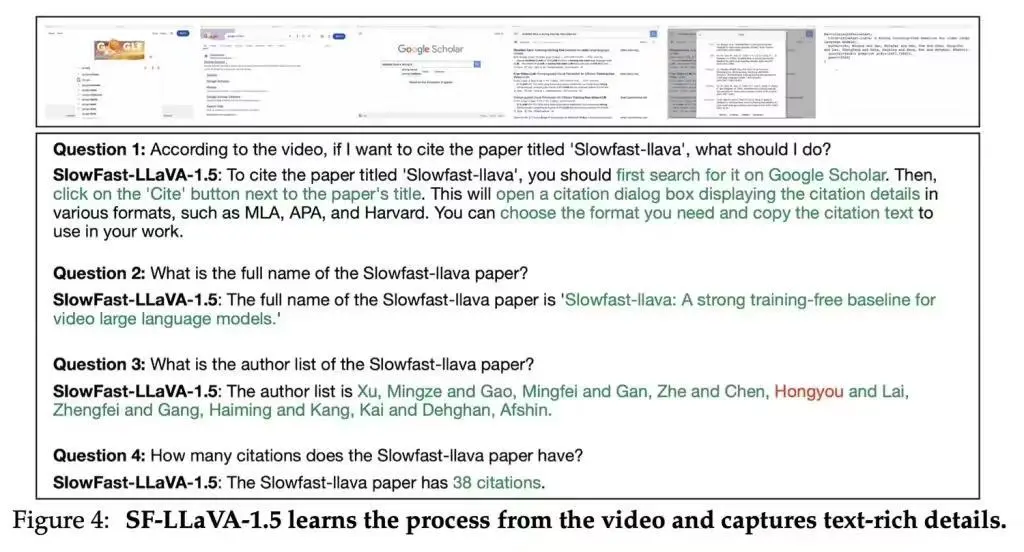

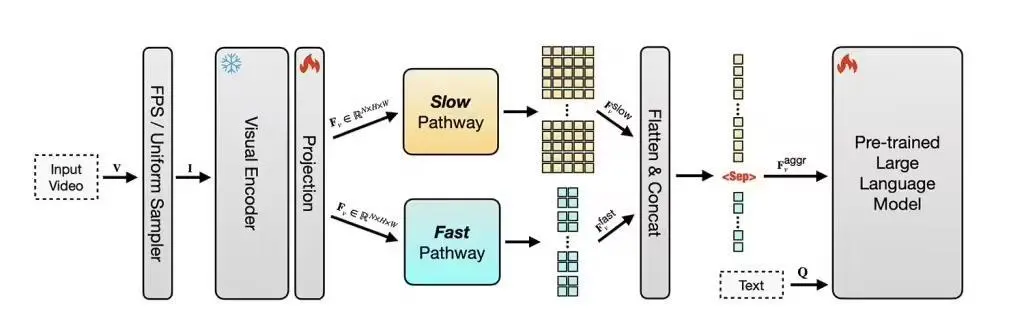

蘋果公司針對上述 3 個局限性,首先研究推出了 SlowFast-LLaVA 開源模型,最大的亮點是創(chuàng)新雙流(two-stream)設置,其中“慢流”選取少量高分辨率幀捕捉場景細節(jié),“快流”選取更多低分辨率幀追蹤運動變化。

蘋果進一步在開源模型 SlowFast-LLaVA 模型上,通過微調(diào)圖像模型,進一步增強視覺推理能力,再聯(lián)合圖像與視頻訓練,保留圖像理解優(yōu)勢,推出了 SlowFast-LLaVA-1.5 版本。

在設計上,SF-LLaVA-1.5 將輸入視頻幀數(shù)固定為 128,其中快流 96 幀,慢流 32 幀,適配各種時長視頻。這種方法雖可能漏掉關鍵幀或影響播放速度判斷,但顯著降低了計算和顯存需求。研究團隊指出,可通過引入內(nèi)存優(yōu)化技術(如隨機反向傳播)進一步改進,但需解決高顯存占用問題。

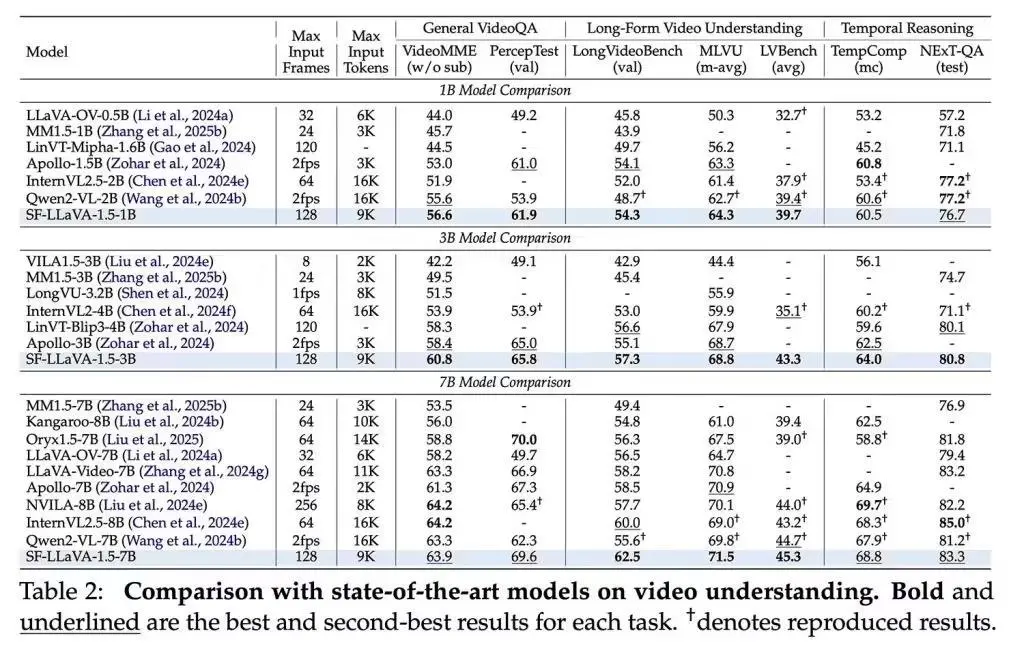

測試顯示,該模型在長視頻基準 LongVideoBench、MLVU 上均取得新紀錄,而且 1B 版本也能領先競爭對手。同時,它在知識問答、數(shù)學推理、OCR 等圖像相關任務上表現(xiàn)出色,實現(xiàn)視頻與圖像的通用理解能力。

該項目完全基于公開數(shù)據(jù)集訓練,方便學術與產(chǎn)業(yè)復現(xiàn),并已在 GitHub 與 Hugging Face 開源。